蘇州2018年12月12日電 /美通社/ — 聽覺作為人類感知手段之一,幾十年來一直是不少研究人員的重點領域。西交利物浦大學計算機科學和軟件工程系的 Andrew Abel 博士和他的團隊設計了一個新系統,他們在助聽器中加入了捕捉人說話時唇形特徵的視覺信號,以提高助聽器的使用效果。他們的最新研究成果也在2018年IEEE計算智能研討會( IEEE-SSCI 2018 )上進行發表。

Abel博士介紹說,很多傳統的助聽器都是通過放大患者接收不到的聲音頻率來達到助聽效果;有些助聽器內安置了除噪音的算法,能夠降低對話之外的聲音音量;還有一些帶有定向麥克風,能夠探測到來自某些特定方向的聲音。

「但是人們聊天的時候不僅僅是靠聲音來交流的。」Abel博士說,「人們還會相互觀察面部表情、肢體語言,而且或多或少都會觀察對方的唇部動作。」

比如,當人們聽到「ba」這個音節,但是看到的是「fa」這個音節的唇部動作,人們就會誤以為自己聽到的是「fa」甚至是「va」。

「這被稱為『麥格克效應』。」 Abel博士解釋說,「大腦在同時接收到一個視覺信息和一個聽覺信息的時候,有可能視覺信息會覆蓋掉聽覺信息並造成視聽幻覺。」

這種現象充分展示了視覺信息在談話中的重要性。因此Abel博士和他的團隊一直在思考:如何才能開發出接收聲音以外信息的機器?如何讓這些機器像人類一樣去「聽」?

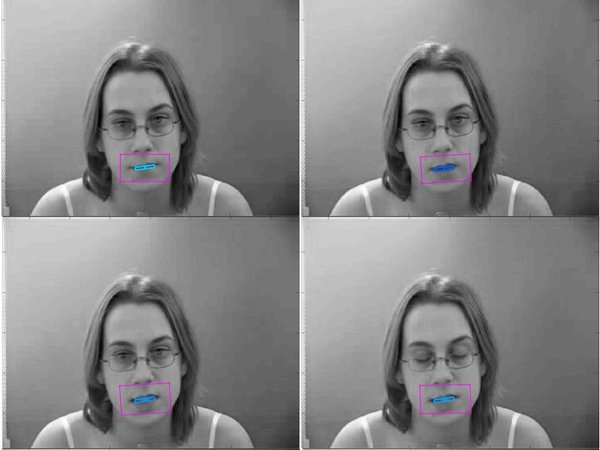

Abel博士在就職於蘇格蘭斯特靈大學時和Amir Hussain教授一起研究過助聽科技,他們嘗試把一個可穿戴的小型照相機連接到助聽器上,讓系統同時處理接收到的聽覺和視覺信息。在這些視覺信息中,會影響系統處理結果的是唇部動作、嘴巴張開或閉合、寬度及深度等唇形特徵。

受到之前研究的啟發,Abel博士、西浦計算機系畢業生高成翔以及斯特靈大學研究人員聯合開發了一個新系統,專門記錄唇形特徵信息並建立唇部的3D模型。

「這個3D模型可以用來確定說話時的音量和音調特徵,這些特徵有利於提高助聽器的降噪功能,也能運用於我們在研究的唇語讀取。」 Abel博士補充說。

他正在指導一項將唇讀科技運用於對外漢語教學的畢業設計,只要系統接收到正確的視覺和聽覺信號就可以區分不同的中文發音,這些信息會自動反饋給學習漢語的人。

「中文是一種聲調語言,發音和其他語言不太一樣,學好正確發音是有一定難度的。」

Abel博士研究的另一個領域是利用圖像識別技術來改善助聽器過濾噪音的效果。例如,攝像機可以識別出用戶所處的環境是安靜的辦公室還是喧鬧的酒吧,根據環境的不同可以採取不同的噪音過濾方法。

「在大腦處理聲音的時候,感知效應是非常重要的一部分。」Abel博士說。

比如人們會根據環境聲音的大小來調整自己的說話聲音,這被稱為「倫巴效應」。此外,聽力正常的人在嘈雜的環境中也可以進行高效溝通,這是因為大腦自動忽略掉了其他人的說話聲音以及無關的環境音,這被稱為「雞尾酒會效應」。

「目前我們無法將所有視覺信息整合到助聽器中,但是我們正在朝著『感知型助聽器』這個方向努力。」

Abel博士和他的同事希望能夠將詞語識別和預判對話結合,同時整合環境識別及其他視覺信息處理手段,有一天能創造出能夠像人一樣「思考」的改進型助聽器。

「在我們理解並複製人耳處理聲音的過程時,我們不僅能改良助聽器科技,還學到了很多關於人類自身及人腦思維運作方式的知識。」他說。

閱讀原文請訪問:https://www.xjtlu.edu.cn/zh/news/2018/12/xipuxuezheyanjiuxinxingzhutingqi